RAG trifft Knowledge Graph: Ein neues Level der Chatbot-Interaktion

Zurück zum BlogEin Beitrag von Roman Senger, Channel Sales Manager bei Empolis

Die Integration von Knowledge Graphen in LLM-Chatbots kennzeichnet eine bedeutende Weiterentwicklung im Bereich der Informationsverarbeitung. Durch die systematische Strukturierung von Daten entsteht eine leistungsfähige Plattform, die es den Chatbots ermöglicht, nicht nur auf Anfragen zu reagieren, sondern auch tiefergehende Verständnis- und Lernprozesse zu vollziehen. Dies führt zu einer verbesserten Fähigkeit, komplexe Probleme zu diagnostizieren, individuelle Lösungen anzubieten und potenzielle Entwicklungen vorauszusehen. Der Knowledge Graph fungiert hierbei als zentraler Mechanismus, der es den Chatbots ermöglicht, relevante Informationen zu verknüpfen und kontextualisiert bereitzustellen, was zu einer effektiveren Interaktion zwischen Mensch und Maschine führt.

Wo das menschliche Denken auf die menschliche Rede trifft

Die Erweiterung des Retrieval Augmented Generation (RAG)-Ansatzes um die Integration mit Knowledge Graphen markiert den hybriden state-of-the Art Ansatz, um natürlichsprachig mit Wissen zu interagieren. Diese Synergie zwischen RAG und Knowledge Graphen eröffnet neue Dimensionen der Interaktionsqualität und Antwortgenauigkeit, die weit über das hinausgehen, was mit herkömmlichen, auf unstrukturierten Dokumenten, wie PDFs, Excel etc. basierenden Systemen möglich ist. Der Schlüssel zu diesem Fortschritt liegt in der strukturierten Natur der Knowledge Graphen, die eine semantisch reiche, miteinander verbundene Datenlandschaft bieten.

Was ist ein Knowledge Graph?

Im Herzen vieler Lösungen, die wir täglich nutzen, liegt eine Technologie, die die Art und Weise, wie wir Menschen denken und Wissen speichern in digitale Form übersetzt. Um die Tiefe und Komplexität dieses Unterfangens zu verstehen, lassen Sie uns einen Moment aus dem echten Leben betrachten, einen, der die Kraft der menschlichen Kognition und die Möglichkeit ihrer Nachahmung durch Knowledge Graphen aufzeigt.

Stellen Sie sich vor, ich spreche mit meinem vierjährigen Sohn über Autos. Er ist fasziniert von der Tatsache, dass einige Autos Geräusche machen, während andere fast lautlos fahren. Das will er verstehen, und um ihm dies zu erklären, baue ich eine einfache Argumentationskette auf, die ein Vierjähriger nachvollziehen kann. Ich erkläre ihm, dass es zwei Arten von Autos gibt: Verbrenner und Elektroautos. Die Autos mit Verbrennungsmotoren, so sage ich, haben einen Tank, der mit Benzin gefüllt wird – eine Flüssigkeit, die sie von der Tankstelle im Nachbarort „trinken“. Dieses Benzin wird im Motor verbrannt, es explodiert regelrecht, ähnlich einem Feuerwerk, nur viel öfter und schneller. Dieses Geräusch der Explosionen ist es, was wir hören.

Dann erkläre ich ihm die Elektroautos. Diese Autos werden nicht mit Benzin betankt, sondern mit Strom geladen, ähnlich wie wir Spielzeug über die Steckdose aufladen. Da hier nichts verbrannt wird, sind sie sehr leise.

Wenn ich meinen Sohn später frage, ob ein Auto, das von der Tankstelle kommt, ein Elektroauto oder ein Verbrenner ist, wird er wahrscheinlich richtig antworten, dass es ein Verbrenner ist. Dies liegt daran, dass er die Informationen nicht einfach als lose Fakten gespeichert hat. Stattdessen hat er sie in einem mentalen Modell organisiert, das Beziehungen zwischen verschiedenen Konzepten – Autos, Benzin, Tankstellen, Geräusche – herstellt. Diese Geschichte illustriert, wie bereits im jungen Alter unser Gehirn fähig ist, Wissen in einem vernetzten System von Ursache und Wirkung zu speichern.

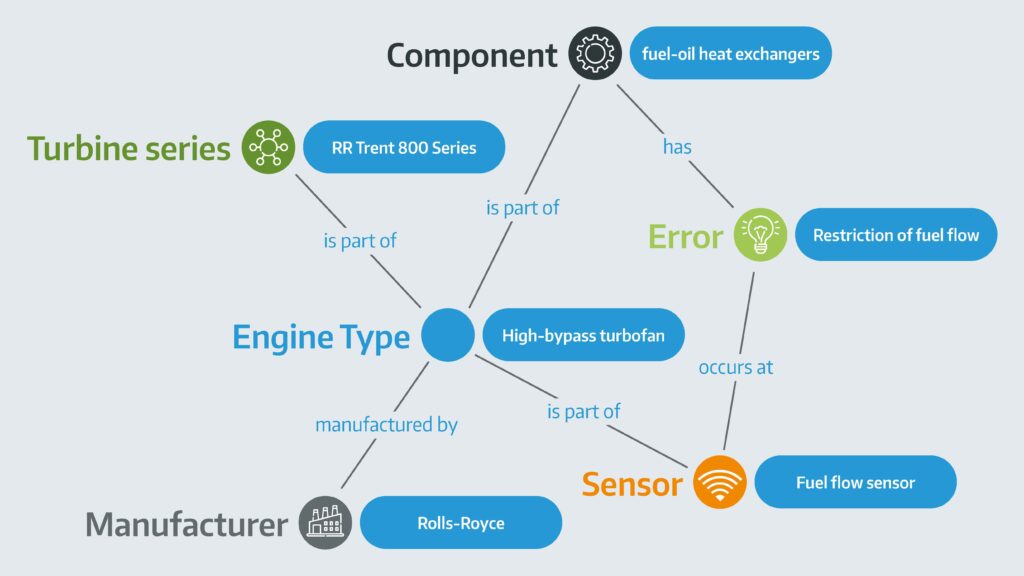

Genau diese Fähigkeit, Wissen in einem vernetzten System zu speichern und abzurufen, versuchen wir mit Knowledge Graphen in der digitalen Welt nachzubilden. Ein Knowledge Graph ist eine Darstellung von Wissen in einer Graphenstruktur, bei der Entitäten durch Kanten miteinander verbunden sind, die ihre Beziehungen zueinander repräsentieren. Diese Entitäten können Konzepte, Orte, Objekte oder Personen sein, und die Kanten beschreiben, wie diese Entitäten miteinander in Beziehung stehen.

Die Integration eines solchen Knowledge Graphen in einen Chatbot verschiebt die Grenzen dessen, was mit künstlicher Intelligenz möglich ist. Statt sich auf eine Datenbank mit vorgefertigten Antworten zu verlassen, kann ein auf einem Knowledge Graphen basierender Chatbot komplexe Anfragen durch das Verständnis der Beziehungen zwischen verschiedenen Entitäten beantworten. Er kann Schlussfolgerungen ziehen und Antworten generieren, die nicht nur relevant, sondern auch kontextuell angepasst sind.

Ein solcher Ansatz ermöglicht es dem Chatbot, ähnlich wie mein Sohn, komplexe Zusammenhänge zu verstehen und Fragen zu beantworten, die ein tiefes Verständnis der Materie erfordern. Der Chatbot könnte erkennen, dass ein Auto, das gerade von der Tankstelle kommt, wahrscheinlich mit Benzin betrieben wird und daher ein Verbrennungsmotor ist. Diese Fähigkeit, Wissen nicht nur zu speichern, sondern auch in einem Kontext zu interpretieren und anzuwenden, eröffnet neue Dimensionen der Interaktion und des Wissensaustauschs zwischen Mensch und Maschine.

Durch die Nachbildung der Art und Weise, wie Menschen denken und Wissen organisieren, bringen Knowledge Graphen uns einen Schritt näher an die Schaffung von Technologien, die nicht nur Informationen liefern, sondern auch verstehen und darauf aufbauen können. Sie ermöglichen eine Form der künstlichen Intelligenz, die nicht nur reagiert, sondern auch lernt, versteht und sich anpasst – ähnlich einem neugierigen Kind, das die Welt um sich herum entdeckt.

LLM Chatbots mit unterschiedlichem RAG Ansatz: Knowledge Graph vs. Dokumente

Um die Vorteile eines auf Knowledge Graphen oder RAG-Prinzip basierenden LLM-Chatbots im Bereich des Service-Managements zu verdeutlichen, insbesondere im Vergleich zu einem System, das auf unstrukturierten Daten wie PDFs zugreift, konzentrieren wir uns auf konkrete Beispiele aus dem Support und dem Field Service. Diese Beispiele illustrieren, wie die Integration eines Knowledge Graphen oder des RAG-Prinzips die Effizienz und Effektivität der Serviceleistungen steigern kann.

Beispiele

Beispiel 1: Komplexe Fehlerdiagnose im technischen Support

Knowledge Graph+RAG-LLM-Chatbot: Ein Kunde meldet ein Problem mit einem komplexen Gerät, wie z.B. einem industriellen Drucker. Der auf einem Knowledge Graphen basierende Chatbot analysiert die Fehlerbeschreibung und vergleicht sie mit ähnlichen Fällen und deren Lösungen. Durch die Vernetzung von Informationen zu Gerätetypen, bekannten Problemen, Softwareversionen und Fehlercodes kann der Chatbot gezielte Fragen zur Fehlerdiagnose stellen und präzise Lösungsvorschläge unterbreiten. Zum Beispiel könnte der Chatbot erkennen, dass der Fehler häufig bei einer bestimmten Softwareversion auftritt und ein spezifisches Update empfehlen.

Unstrukturierte Daten-LLM-Chatbot: Ein Chatbot, der nur Zugriff auf eine Sammlung von Handbüchern und technischen Dokumenten hat, kann dem Kunden generelle Lösungsansätze bieten, wie z.B. einen Neustart des Geräts oder die Überprüfung der Kabelverbindungen. Allerdings fehlt ihm die Fähigkeit, tiefergehende Diagnosen zu stellen oder spezifische Lösungen für die Softwareversion oder den Fehlercode zu bieten.

Beispiel 2: Ersatzteilbestellung im Field Service

Knowledge Graph+RAG-LLM-Chatbot: Ein Service-Techniker vor Ort benötigt dringend ein Ersatzteil für eine Reparatur. Der Chatbot kann sofort die Kompatibilität des Ersatzteils mit dem spezifischen Modell des Geräts überprüfen, Verfügbarkeit prüfen und alternative Optionen vorschlagen, falls das benötigte Teil nicht sofort verfügbar ist. Durch die Verbindung von Produktinformationen, Lagerbeständen und Lieferlogistik kann der Chatbot dem Techniker helfen, die Reparatur effizient zu planen und durchzuführen.

Unstrukturierter Daten-LLM-Chatbot: Bei Zugriff auf unstrukturierte Daten wie Produktkataloge oder Lagerbestandslisten könnte der Chatbot Informationen zu Ersatzteilen liefern, aber ohne direkte Verknüpfung zu spezifischen Gerätemodellen oder aktuellem Lagerbestand. Dies könnte zu Verzögerungen führen, wenn der Techniker erst manuell die Kompatibilität überprüfen und die Verfügbarkeit klären muss.

Beispiel 3: Anleitungen für die Problembehebung

Knowledge Graph+RAG-LLM-Chatbot: Bei einem Problem mit einer Softwareanwendung kann der Chatbot durch Verständnis der Anwendungsarchitektur und häufiger Fehlerquellen gezielte Schritte zur Problembehebung anbieten. Wenn ein Nutzer zum Beispiel Probleme mit dem Druck in einem Buchhaltungsprogramm meldet, kann der Chatbot sofort erkennen, dass ein aktuelles Update spezifische Druckprobleme adressiert und dem Nutzer eine detaillierte Anleitung zur Aktualisierung geben.

Unstrukturierte Daten-LLM-Chatbot: Ein Chatbot, der sich auf eine Datenbank mit generischen Anleitungen stützt, könnte dem Nutzer allgemeine Tipps zur Fehlerbehebung geben, wie z.B. die Überprüfung der Druckereinstellungen oder einen Neustart des Programms. Diese Vorschläge könnten hilfreich sein, bieten aber keine spezifischen Lösungen für bekannte Fehler, die durch Updates behoben wurden.

Beispiel 4: Vorausschauende Wartungsempfehlungen

Knowledge Graph+RAG-LLM-Chatbot: Auf Basis der Service-Historie und der Datenanalyse von Geräteausfällen kann der Chatbot vorausschauende Wartungsempfehlungen aussprechen. Für ein Fahrzeugflottenmanagement könnte der Chatbot zum Beispiel erkennen, dass bestimmte Fahrzeugtypen bei bestimmten Kilometerständen zu spezifischen Problemen neigen und dementsprechend eine präventive Wartung empfehlen.

Unstrukturierte Daten-LLM-Chatbot: Ohne die Fähigkeit, komplexe Muster in den Daten zu erkennen und diese mit spezifischen Wartungsempfehlungen zu verknüpfen, könnte ein Chatbot nur allgemeine Wartungsintervalle basierend auf Herstellerangaben vorschlagen. Dadurch werden potenzielle spezifische Probleme, die durch die Analyse von Service-Daten identifiziert werden könnten, nicht adressiert.

Die hier präsentierten Beispiele sind nur ein Ausschnitt aus einer Vielzahl möglicher Szenarien, die die Potenziale und Herausforderungen im Umgang mit LLM-Chatbots aufzeigen, insbesondere wenn diese mit Knowledge Graphen oder auf Basis des RAG-Prinzips arbeiten. Sie illustrieren, dass für eine optimale Nutzererfahrung nicht nur eine durchdachte KI-Infrastruktur entscheidend ist, sondern auch die Qualität und Struktur der Informationsbasis, auf die der Chatbot zugreift.

Diese Beispiele unterstreichen die Bedeutung einer sorgfältigen Planung und Implementierung der Informationsgrundlage, die den Kern eines jeden intelligenten Systems bildet. Eine wohlstrukturierte, vernetzte und reichhaltige Datenquelle kann die Fähigkeit eines Chatbots, präzise, kontextbezogene und hilfreiche Antworten zu geben, signifikant verbessern. Dies wiederum steigert die Zufriedenheit und das Engagement der Nutzer.

Pro und Contras von Knowledge Graph-basierten LLM-Chatbots

Für wertvolle Erkenntnisse gibt es keinen königlichen Weg. Dies gilt insbesondere für die Integration und Nutzung von Knowledge Graphen in LLM-Chatbots. Die Entscheidung, sich dieser fortschrittlichen Technologie zu widmen, ist kein leichtfertiger Schritt. Wäre die Umsetzung trivial, hätten längst alle Unternehmen diesen Weg beschritten.

Die Implementierung eines Knowledge Graph-basierten Systems signalisiert einen hohen Reifegrad des Wissensmanagements innerhalb einer Organisation. Nicht jedes Unternehmen ist bereit oder in der Lage, direkt auf diese Stufe zu springen. Es bedarf einer sorgfältigen Abwägung der Vor- und Nachteile, um eine fundierte strategische Entscheidung treffen zu können. Für Entscheidungsträger ist es daher essenziell, die Komplexität und die potenziellen Vorteile gegen den erforderlichen Aufwand und die möglichen Einschränkungen abzuwägen.

Diese Entscheidung basiert nicht nur auf einer technischen Evaluation, sondern auch auf einer umfassenden Betrachtung der Organisationsstruktur, der vorhandenen Datenqualität und -verfügbarkeit sowie der langfristigen Unternehmensziele. Die Implementierung eines Knowledge Graphen ist mehr als nur ein technisches Projekt; es ist ein strategisches Vorhaben, das tiefgreifende Veränderungen in der Art und Weise, wie Informationen verwaltet und genutzt werden, mit sich bringt.

Letztlich geht es darum, eine Brücke zwischen dem aktuellen Stand des Wissensmanagements und dem visionären Ziel einer intelligenten, datengesteuerten Organisation zu schlagen. Die Pro- und Contra-Liste dient als Leitfaden, der auf unseren Erfahrungen in solchen Projekten basiert, und soll Entscheidungsträgern helfen, die Komplexität dieses Unterfangens zu navigieren und eine wohlüberlegte Wahl zu treffen.

Pro:

- Präzision und Kontextbezogenheit: Durch die Verwendung von Knowledge Graphen können LLM-Chatbots gezieltere und kontextuell passendere Antworten liefern, da sie die Beziehungen zwischen verschiedenen Informationen verstehen und nutzen können.

- Effiziente Informationsverarbeitung: Knowledge Graphen ermöglichen eine schnellere und effizientere Verarbeitung von Anfragen, da relevante Informationen und ihre Verbindungen direkt abgerufen werden können, ohne große Mengen unstrukturierter Daten durchsuchen zu müssen.

- Flexible Anpassungsfähigkeit: Die modulare Struktur von Knowledge Graphen erleichtert die Aktualisierung und Erweiterung der Informationsbasis, was die Langlebigkeit und Anpassungsfähigkeit des Systems an neue Anforderungen oder Wissensbereiche verbessert.

- Verbessertes Nutzererlebnis: Eine tiefere Verständnisebene und die Fähigkeit, komplexe Anfragen zu bearbeiten, führen zu einem verbesserten Nutzererlebnis, da die Antworten des Chatbots relevanter und nützlicher sind.

Contra:

- Aufwendige Erstellung und Pflege: Der Aufbau und die Pflege eines umfangreichen und detaillierten Knowledge Graphen können zeit- und ressourcenintensiv sein, insbesondere in Bezug auf die Datenerfassung und -strukturierung.

- Komplexität bei der Integration: Die Integration eines Knowledge Graphen in ein LLM-Chatbot-System kann technisch anspruchsvoll sein, da es eine enge Verzahnung zwischen der KI-Infrastruktur und der Datenstruktur erfordert.

- Potenzielle Einschränkungen der Kreativität: Die Abhängigkeit von strukturierten Daten kann in einigen Fällen die kreativen Antwortmöglichkeiten des Chatbots einschränken, insbesondere wenn unerwartete oder sehr spezifische Nutzeranfragen auftreten, die außerhalb des abgedeckten Wissensbereichs liegen. Möglicherweise ist dies aber auch bewusst gewollt, um kein Wissen außerhalb des Graphen auszugeben.

Fazit

Knowledge Graph-basierte LLM-Chatbots können eine leistungsstarke Möglichkeit sein, komplexe Informationen effizient zu verarbeiten und Nutzern präzise, kontextbezogene Antworten zu liefern. Die Entscheidung für diese Technologie sollte sorgfältig abgewogen werden, indem man die Vorteile gegen die Herausforderungen und den erforderlichen Aufwand abwägt.

Je einfacher das Produktportfolio in der Tiefe (Komplexität) und Breite (Vielfalt) gestaltet ist, desto weniger wirtschaftlich ist es einen Knowledge Graphen als Repräsentation zu verwenden. Andererseits eröffnet ein reichhaltiges und komplexes Produktportfolio, das durch einen Knowledge Graphen abgebildet wird, erhebliche Vorteile. In solchen Fällen verbessert der Knowledge Graph nicht nur die Handhabung und Analyse von Informationen erheblich, sondern trägt auch dazu bei, neue Einsichten und Verbindungen innerhalb des Produktportfolios zu entdecken, die Innovationen und verbesserten Kundenservice vorantreiben.

Es sei noch hervorzuheben, dass ein Knowledge Graph nicht nur Chatbots, sondern auch viele verschiedene Anwendungen, Touchpoints und Nutzungsszenarien mit derselben semantischen Logik versorgen kann, doch eine umfassende Abhandlung dieser Möglichkeiten würde den Rahmen dieses Kapitels bei Weitem sprengen. Die Wahl der richtigen Informationsgrundlage und die sorgfältige Planung der KI-Infrastruktur sind entscheidend, um die bestmögliche Nutzererfahrung zu gewährleisten.